2024-06-13 08:31:03

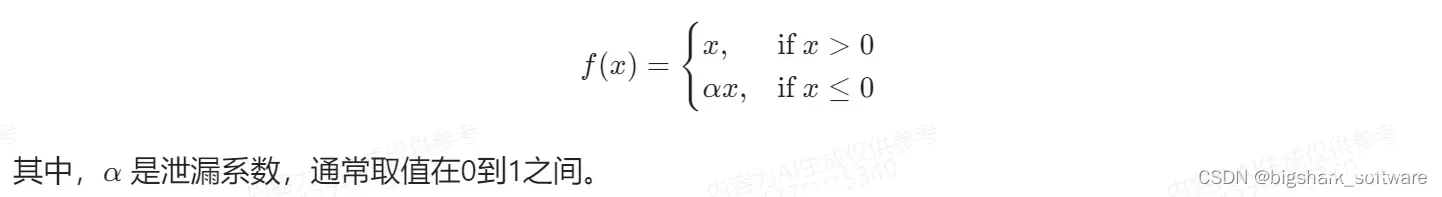

然而,当使用ReLU激活函数时,可能会遇到训练缓慢的问题,尤其是在网络的早期层,因为梯度可能会在网络的反向传播过程中消失(即,梯度变为非常小的值,接近零)。LeakyReLU是一种修正线性单元(Rectifie...

浏览 58 次 标签: 2024-04-05 问AI: 介绍一下深度学习中的Leaky ReLU函数

阅读排行

- 主角杨玄天 核爆后,还被抢亲?我杀疯了!的小说在线阅读 精品《杨玄天姬如烟》小说在线阅读

- 往昔爱意成灰(裴司誉简云初)全文完整版免费阅读_往昔爱意成灰最新章节列表_笔趣阁(裴司誉简云初)

- 最新小说《玄竹湘柔》大结局阅读 玄竹湘柔小说全文在线阅读

- 小说秦心宁秦泽安 第一章 新书《秦心宁秦泽安》小说全集阅读

- (完本)大结局小说《敖凡青云子》在线阅读 精品《敖凡青云子》小说在线阅读

- 九胤赤瑶(赤瑶九胤小说)全文免费阅读无弹窗大结局_赤瑶九胤完整版小说阅读

- 苏心妍薄靳言未删减阅读 霜珑小说全文免费试读

- 宋青书张无忌by综武:重生宋青书的我,正的发邪第1章 泡澡的松鼠小说全部章节目录

- 沈聿风纪青语by沈聿风,我们离婚吧在线阅读 阿辰小说精彩章节在线阅读

热门文章

- 北大荒:都重生了谁还回城?新书苏怀安秦灵在线阅读 大教授小说全文免费试读

- 浅浅顾言苏锦最新章节 3 胖茄子小说精彩章节在线阅读

- (番外)+(结局)真千金她一抬眸,海城大佬齐低头(沈幼梧厉北暝:完结+结局+番外)全文免费阅读无弹窗大结局_(真千金她一抬眸,海城大佬齐低头)最新章节列表_笔趣阁(沈幼梧厉北暝:完结+结局+番外)

- 主角霜珑 小说苏心妍薄靳言在线阅读 精品《苏心妍薄靳言》小说在线阅读

- 小说苏瑾年沈向东完整版在线阅读 大雪小说精彩章节在线阅读

- 【抖音】《浅浅顾言苏锦》胖茄子免费试读 小说全集免费在线阅读(胖茄子)

- 【抖音】小说苏瑾年沈向东无广告阅读 大雪小说全本无弹窗

- (无弹窗)小说崔瑶音沈云锦元安 作者太子退婚娶孤女后,悔疯了 (会跳舞的棉花糖)小说全集免费在线阅读

- (番外)+(全文)穿越海岛求生,我有空间小世界!君弑臣上官婉儿:全文+后续+结局(君弑臣上官婉儿)全文免费阅读无弹窗大结局_穿越海岛求生,我有空间小世界!:全文+后续+结局最新章节列表_笔趣阁(穿越海岛求生,我有空间小世界!君弑臣上官婉儿:全文+后续+结局)

名师推荐

- (爽文)杨玄天姬如烟全本章节阅读 精品《杨玄天姬如烟》小说在线阅读

- 第六章小说无广告阅读 苏璞小说 苏璞小说全部章节目录

- 无广告小说沐渐青云衔川 木宅在线阅读 (木宅)小说全集免费在线阅读

- 顾砚初宋雪音(宋雪音顾砚初)全文免费阅读无弹窗大结局_顾砚初宋雪音最新章节列表-笔趣阁宋雪音顾砚初

- 全网首发凤宁敖玄苍小说叫什么(敖玄苍凤宁)(凤宁敖玄苍)全书阅读纯净阅读

- 敖玄苍凤宁小说全篇完整在线阅读(凤宁敖玄苍)热门章节列表

- (完整版未删节)小说敖凡青云子 第2章 爱吃辣的小子小说精彩章节在线阅读

- 秦心宁秦泽安by时间向前,回忆消散 第一章 秦心宁秦泽安小说全文在线阅读

- (独家)魏迟沈梨小说 回风流玉小说精彩章节在线阅读